Les escroqueries liées à l'IA expliquées : comment fonctionne la fraude basée sur l'IA et comment les entreprises la détectent

Aperçu de la situation

- Les escroqueries liées à l'IA ont augmenté de 1 210 % en 2025, dépassant largement la croissance de 195 % des fraudes traditionnelles, et les pertes prévues pourraient atteindre 40 milliards de dollars d'ici 2027.

- Sept types distincts d'escroqueries basées sur l'IA ciblent désormais les entreprises, parmi lesquelles l'usurpation d'identité par vidéo deepfake, le clonage vocal par IA et les attaques BEC (Business Email Compromise) basées sur l'IA représentent le risque le plus élevé pour les organisations.

- Les défenses traditionnelles échouent. phishing généré par l'IA phishing les erreurs grammaticales, les messages génériques et les limitations manuelles sur lesquels s'appuyaient les filtres de messagerie traditionnels et les formations de sensibilisation pour détecter les fraudes.

- La détection comportementale comble cette lacune. détection et réponse aux incidents NDR) et la détection et la réponse aux menaces d'identité (ITDR) détectent les anomalies dans les modèles de réseau, d'identité et de flux de données que les outils de sécurité basés sur le contenu ne parviennent pas à repérer.

- La vérification par couches est désormais obligatoire. Les contrôles financiers à double approbation, la vérification hors bande et les phrases de code pré-partagées réduisent les risques lorsque n'importe quel canal de communication peut être reproduit de manière synthétique.

La fraude alimentée par l'IA n'est plus un risque théorique. Rien qu'en 2024, le FBI IC3 a enregistré 16,6 milliards de dollars de pertes liées à la cybercriminalité, soit une augmentation de 33 % par rapport à l'année précédente, l'ingénierie sociale améliorée par l'IA étant à l'origine d'une part croissante de ces incidents. Un seul appel vidéo deepfake a coûté 25,6 millions de dollars à la société d'ingénierie Arup. Le phishing généré par l'IA phishing générés par l'IA atteignent désormais des taux de clics plus de quatre fois supérieurs à ceux de leurs homologues créés par des humains. Et selon le Global Cybersecurity Outlook 2026 du Forum économique mondial, 73 % des organisations ont été directement touchées par la fraude cybernétique en 2025.

Ce guide explique comment fonctionnent les escroqueries basées sur l'IA, les types les plus fréquemment rencontrés par les équipes de sécurité, les dernières données relatives aux pertes et, surtout, comment les entreprises détectent et réagissent aux fraudes basées sur l'IA lorsque les défenses traditionnelles s'avèrent insuffisantes.

Que sont les escroqueries liées à l'IA ?

Les escroqueries basées sur l'IA sont des stratagèmes frauduleux qui utilisent l'intelligence artificielle (notamment les grands modèles linguistiques, le clonage vocal, la génération de vidéos deepfake et les agents IA autonomes) pour tromper les victimes à une échelle et avec un niveau de sophistication jusqu'alors impossibles, éliminant ainsi les limites humaines qui rendaient l'ingénierie sociale traditionnelle détectable et lente.

Alors que les escroqueries traditionnelles dépendaient des efforts, des compétences linguistiques et du temps consacrés par l'attaquant humain, les escroqueries basées sur l'IA suppriment totalement ces contraintes. L'attaquant n'a plus besoin de maîtriser la langue de la cible. Il n'a plus besoin de rédiger manuellement des messages personnalisés. Et il n'a plus besoin de passer des heures à préparer une seule tentative.

Le rapport international sur la sécurité de l'IA 2026 a révélé que les outils d'IA utilisés pour ces escroqueries sont gratuits, ne nécessitent aucune expertise technique et peuvent être utilisés de manière anonyme. Cette combinaison (coût nul, aucune compétence requise, aucune responsabilité) explique pourquoi la fraude liée à l'IA connaît une croissance plus rapide que toute autre catégorie de menaces.

Au-delà des pertes financières directes, les escroqueries basées sur l'IA créent un effet de « dégradation de la vérité ». À mesure que les vidéos deepfake, les voix clonées et les textes générés par l'IA deviennent impossibles à distinguer des communications authentiques, les organisations perdent la capacité de se fier à toute interaction numérique telle quelle. Chaque appel vidéo, message vocal et e-mail devient suspect.

En quoi les escroqueries basées sur l'IA diffèrent-elles des escroqueries traditionnelles ?

Le changement fondamental réside dans la rapidité et la qualité à grande échelle. Les escroqueries traditionnelles reposaient sur l'effort humain et comportaient des défauts détectables : fautes d'orthographe, formulations maladroites, formules de politesse génériques. Les escroqueries basées sur l'IA permettent d'obtenir un résultat de qualité humaine à la vitesse d'une machine.

Prenons phishing . Selon une étude menée par IBM X-Force, l'IA est capable de générer un phishing convaincant en cinq minutes. Un chercheur humain mettrait 16 heures à rédiger manuellement un e-mail de même qualité. Cela représente un gain de vitesse de 192 fois pour une qualité équivalente ou supérieure. En d'autres termes, un seul pirate informatique peut désormais produire en une journée ce qui nécessitait auparavant plusieurs mois de travail à une équipe de spécialistes.

Les implications s'amplifient à grande échelle. L'IA ne se contente pas d'égaler la qualité humaine. Elle personnalise chaque message à l'aide de données extraites des profils LinkedIn, des documents déposés par les entreprises et des réseaux sociaux. Une étude réalisée en 2024 par Brightside AI a révélé que phishing générés par l'IA atteignaient un taux de clics de 54 %, contre 12 % pour phishing traditionnel phishing un multiplicateur d'efficacité de 4,5.

Comment fonctionnent les escroqueries liées à l'IA

Il est essentiel pour les défenseurs de comprendre les outils utilisés par les attaquants. La fraude basée sur l'IA combine plusieurs technologies dans une chaîne d'attaques coordonnées, chaque étape exploitant différentes capacités de l'IA.

Le clonage vocal représente l'un des vecteurs d'attaque les plus accessibles. Une étude menée par McAfee a révélé que trois secondes d'enregistrement audio suffisent pour créer un clone vocal avec une précision de 85 %. Comme l'a rapporté Fortune en décembre 2025, le clonage vocal a franchi le « seuil de l'indiscernabilité », ce qui signifie que les auditeurs humains ne peuvent plus distinguer de manière fiable les voix clonées des voix authentiques.

La génération de vidéos deepfake a évolué, passant de faux évidents à des avatars interactifs en temps réel. Les nouveaux modèles maintiennent une cohérence temporelle sans les artefacts de scintillement, de déformation ou de vallée dérangeante sur lesquels reposaient les méthodes de détection antérieures. Le cas Arup a démontré que les participants à des vidéos deepfake peuvent tromper des professionnels expérimentés lors d'appels en direct.

phishing basé sur le LLM utilise de grands modèles linguistiques pour générer des e-mails hyper-personnalisés qui font référence à des détails organisationnels spécifiques, à des transactions récentes et à des styles de communication individuels. Ces phishing basées sur l'IA ne présentent pas les signes révélateurs que les filtres de messagerie traditionnels ont été formés à détecter.

Les agents frauduleux autonomes représentent la dernière évolution en date. Selon les recherches menées par Group-IB en 2026, les centres d'appels frauduleux basés sur l'IA combinent désormais des voix synthétiques, un coaching basé sur le LLM et des répondeurs IA entrants pour mener des opérations frauduleuses entièrement automatisées à grande échelle.

La chaîne d'outils d'escroquerie à l'IA

Les chaînes d'outils d'escroquerie basées sur l'IA combinent désormais le clonage vocal, les vidéos deepfake et les modèles linguistiques complexes (LLM) pour offrir des services banalisés qui coûtent moins cher qu'un abonnement à une plateforme de streaming.

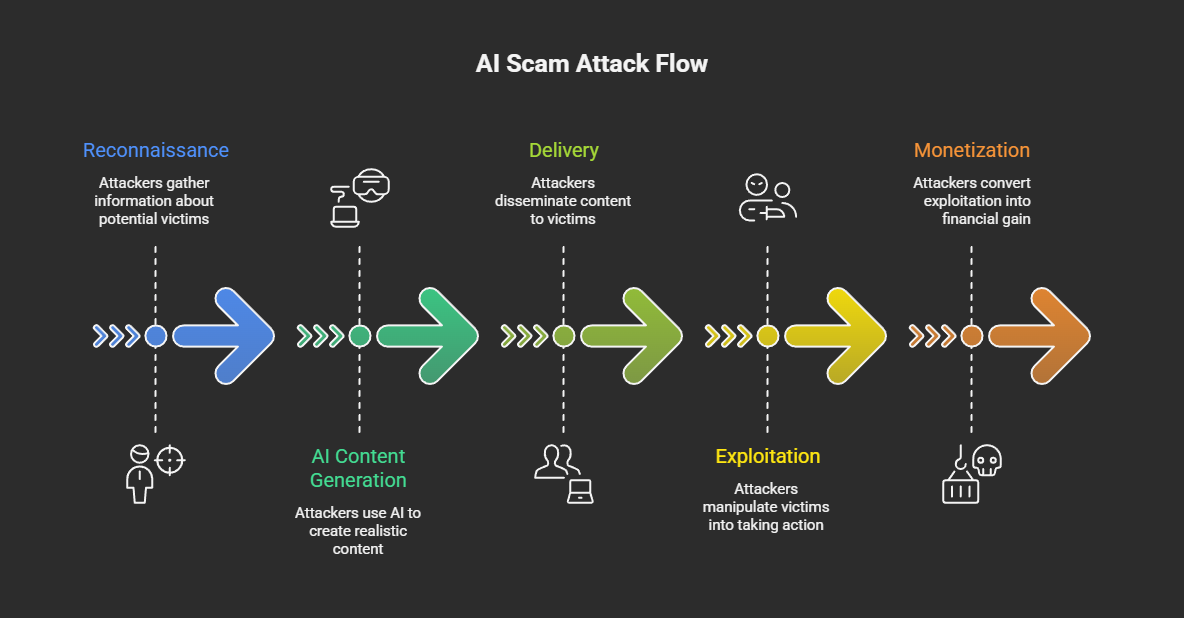

Une attaque typique utilisant l'IA se déroule en cinq étapes :

- Reconnaissance — Les attaquants collectent des données publiques (réseaux sociaux, documents d'entreprise, enregistrements de conférences) afin de créer des profils cibles et de recueillir des échantillons vocaux et vidéo.

- Génération de contenu par IA — À l'aide de modèles linguistiques complexes (LLM), de services de clonage vocal et de générateurs de deepfakes, les pirates créent phishing personnalisés, des messages vocaux synthétiques ou des vidéos deepfake.

- Livraison — Le contenu généré par l'IA atteint ses cibles par e-mail, appels téléphoniques, plateformes de visioconférence, applications de messagerie ou réseaux sociaux.

- Exploitation — Les victimes agissent sur la base de la communication frauduleuse en transférant des fonds, en partageant leurs identifiants, en autorisant l'accès ou en installant des applications malveillantes.

- Monétisation — Les fonds volés transitent par des plateformes d'échange de cryptomonnaies, des passeurs d'argent ou des plateformes d'investissement frauduleuses.

Les facteurs économiques alimentent cette croissance. Le groupe IB a recensé des kits d'identité synthétique disponibles pour environ 5 dollars et des abonnements à des LLM clandestins allant de 30 à 200 dollars par mois. À la fin de 2025, on estimait à huit millions le nombre de deepfakes existant en ligne, contre environ 500 000 en 2023, soit une croissance annuelle d'environ 900 %.

Les barrières à l'entrée ont pratiquement disparu. N'importe qui disposant d'un accès à Internet et d'un petit budget peut désormais lancer des campagnes d'ingénierie sociale basées sur l'IA qui auraient nécessité des ressources au niveau national il y a seulement cinq ans.

Types d'escroqueries liées à l'IA

Les escroqueries basées sur l'IA couvrent désormais sept vecteurs d'attaque distincts, les vidéos deepfake, le clonage vocal et les attaques BEC basées sur l'IA représentant le plus grand risque pour les entreprises. La taxonomie suivante couvre à la fois les variantes ciblant les consommateurs et celles ciblant les entreprises.

Tableau : Taxonomie des types d'escroqueries liées à l'IA avec évaluation des risques pour les entreprises. Légende : Types courants d'escroqueries liées à l'IA, leurs méthodes d'attaque, leurs cibles principales, les niveaux de risque pour les entreprises et les approches de détection recommandées.

Selon ScamWatch HQ, les escroqueries par vidéo deepfake ont augmenté de 700 % en 2025 , Gen Threat Labs ayant détecté 159 378 cas uniques d'escroqueries deepfake au cours du seul quatrième trimestre 2025. Les variantes utilisées par les entreprises comprennent l'usurpation d'identité de cadres lors d'appels vidéo (comme dans le cas Arup), les publicités deepfake usurpant l'identité de cadres financiers et les candidats à un emploi deepfake utilisés par des agents de la RPDC.

Les attaques par clonage vocal et hameçonnage vocal dépassent désormais les 1 000 appels frauduleux par jour chez les grands détaillants. Au-delà du ciblage des consommateurs, les pirates utilisent des voix clonées de cadres supérieurs pour autoriser des virements bancaires frauduleux et se faire passer pour des représentants du gouvernement dans le cadre de campagnes d'ingénierie sociale.

phishing phishing spear phishing générés par l'IA ont atteint un point critique. Une analyse réalisée par KnowBe4 et SlashNext indique que 82,6 % des phishing contiennent désormais du contenu généré par l'IA, tandis que Hoxhunt rapporte que 40 % des e-mails BEC sont principalement générés par l'IA. La différence entre ces chiffres reflète probablement la distinction entre les méthodologies « assistées par l'IA » et celles « entièrement générées par l'IA ».

Selon le FBI IC3, les attaques de type « Business Email Compromise » (BEC) basées sur l'IA ont causé 2,77 milliards de dollars de pertes dans 21 442 incidents en 2024. L'IA transforme les attaques BEC, qui étaient auparavant limitées aux e-mails, en campagnes multimodales combinant e-mails, voix et vidéo afin de créer des usurpations d'identité extrêmement convaincantes.

Les escroqueries liées à l'investissement dans l'IA et aux cryptomonnaies se multiplient rapidement. L'opération « Truman Show » de Check Point a déployé 90 « experts » générés par l'IA dans des groupes de messagerie contrôlés, incitant les victimes à installer des applications mobiles contenant des données commerciales contrôlées par des serveurs. Chainalysis a fait état de 14 milliards de dollars de pertes liées à des escroqueries cryptographiques en 2025, les escroqueries basées sur l'IA s'avérant 4,5 fois plus rentables que les fraudes traditionnelles.

Les escroqueries sentimentales basées sur l'IA utilisent des modèles linguistiques volumineux pour maintenir des conversations émotionnellement intelligentes à grande échelle. Le rapport « 2026 Future of Fraud Forecast » (Prévisions 2026 sur l'avenir de la fraude) d'Experian identifie les robots émotionnellement intelligents alimentés par l'IA comme une menace émergente majeure, capables de maintenir des dizaines de « relations » simultanées tout en adaptant leur ton et leur personnalité à chaque cible.

Escroqueries liées à l'IA visant les entreprises

Les organisations sont confrontées à un sous-ensemble concentré de types d'escroqueries liées à l'IA qui exploitent les relations de confiance et les processus d'autorisation.

L'usurpation d'identité de cadres supérieurs via le deepfake cible les transactions les plus lucratives. L'incident Arup, au cours duquel un employé du service financier a été trompé par un appel vidéo entièrement deepfake incluant le directeur financier apparent, ce qui a donné lieu à 15 transactions distinctes totalisant 25,6 millions de dollars, reste le cas le plus marquant. Il n'a été découvert que grâce à une vérification manuelle effectuée par le siège social de l'entreprise.

Les candidats à l'emploi deepfake représentent une menace émergente et persistante. Le FBI, le ministère américain de la Justice et la CISA ont documenté des stratagèmes mis en place par des informaticiens nord-coréens qui ont touché au moins 136 entreprises américaines, avec des agents gagnant plus de 300 000 dollars par an et passant à l'extorsion de données. Gartner prévoit qu'un profil de candidat sur quatre pourrait être faux d'ici 2028.

phishing spear phishing amélioré par l'IA phishing grande échelle cible des secteurs industriels entiers. Brightside AI a documenté une campagne ciblant 800 cabinets comptables avec des e-mails générés par l'IA faisant référence à des détails d'enregistrement spécifiques à l'État, atteignant un taux de clics de 27 %, bien supérieur à la moyenne du secteur pour phishing .

Les escroqueries liées à l'IA en chiffres : statistiques pour 2024-2026

Les fraudes basées sur l'IA ont augmenté de 1 210 % en 2025, avec des pertes estimées à 40 milliards de dollars d'ici 2027, les outils d'IA démocratisant l'ingénierie sociale à grande échelle.

Tableau : Statistiques sur les escroqueries liées à l'IA et les fraudes par deepfake, 2024-2026. Légende : Principaux indicateurs relatifs aux pertes financières, au volume des attaques et à la prévalence des fraudes basées sur l'IA, provenant de sources faisant autorité.

Remarque sur la portée des données : le chiffre du FBI IC3 (16,6 milliards de dollars) ne représente que les plaintes signalées aux forces de l'ordre américaines et doit être considéré comme un minimum. Le chiffre du GASA (442 milliards de dollars) représente une estimation mondiale incluant les pertes non signalées, basée sur une enquête menée auprès de 46 000 adultes dans 42 pays. Les deux chiffres sont exacts pour leurs méthodologies et leurs portées respectives.

Ces chiffres correspondent directement aux indicateurs de cybersécurité organisationnelle dont les RSSI ont besoin pour établir leurs rapports à l'intention du conseil d'administration et justifier leurs investissements.

Les escroqueries liées à l'IA dans l'entreprise : études de cas concrets

Les pertes liées aux escroqueries impliquant l'IA d'entreprise vont de 25,6 millions de dollars pour une seule fraude par deepfake à des milliards de dollars de pertes annuelles liées au BEC, la cyberfraude dépassant désormais le ransomware en tant que principale préoccupation des PDG.

Le rapport « WEF Global Cybersecurity Outlook 2026 » a révélé un décalage frappant entre les priorités : la fraude cybernétique a dépassé les ransomwares en tant que principale préoccupation des PDG en 2026, mais les ransomwares restent la principale préoccupation de la plupart des RSSI. 72 % des dirigeants ont identifié la fraude liée à l'IA comme un défi opérationnel majeur, et 87 % ont signalé une augmentation des vulnérabilités liées à l'IA.

Appel vidéo deepfake d'Arup — 25,6 millions de dollars

En janvier 2024, un employé du service financier du bureau d'Arup à Hong Kong a été invité à participer à une visioconférence avec ce qui semblait être le directeur financier de l'entreprise et plusieurs collègues. Tous les participants étaient en réalité des deepfakes, générés à partir d'images de conférences accessibles au public. L'employé a autorisé 15 virements bancaires distincts pour un montant total de 25,6 millions de dollars (200 millions de dollars hongkongais). La fraude n'a été découverte que lorsque l'employé a vérifié auprès du siège social de l'entreprise par un autre canal.

Leçon apprise : on ne peut pas se fier uniquement aux appels vidéo pour les autorisations financières. Les organisations doivent mettre en place des contrôles de vérification hors bande et de double approbation pour les transactions de grande valeur.

Candidats à un emploi deepfake en RPDC

Le FBI a recensé des stratagèmes mis en place par des informaticiens nord-coréens qui ont touché au moins 136 entreprises américaines. Les agents utilisent la technologie deepfake pour passer des entretiens vidéo, puis gagnent plus de 300 000 dollars par an tout en reversant leurs revenus aux programmes d'armement de la Corée du Nord. Certains sont passés à l'extorsion de données, menaçant de divulguer des informations confidentielles volées. Gartner prévoit qu'un profil de candidat sur quatre pourrait être faux d'ici 2028.

Fraude à l'investissement « Truman Show » de Check Point

En janvier 2026, les chercheurs de Check Point ont dévoilé une opération utilisant 90 « experts » générés par l'IA pour alimenter des groupes de messagerie contrôlés. Les victimes étaient invitées à installer une application mobile, disponible sur les boutiques d'applications officielles, qui affichait des données boursières contrôlées par le serveur et présentant des rendements fictifs. Les pirates ont créé une réalité entièrement synthétique pour maintenir la fraude.

Modèles de ciblage spécifiques à l'industrie

Différents secteurs sont confrontés à des profils d'escroqueries IA distincts. Les organismes de services financiers sont confrontés à des escroqueries BEC, des fraudes électroniques et des fraudes dans les centres d'appels. Un prestataire de soins de santé américain a signalé que plus de 50 % du trafic entrant consistait en des attaques menées par des robots. Les grands détaillants déclarent recevoir plus de 1 000 appels frauduleux générés par l'IA chaque jour. Les entreprises de recrutement dans les domaines de la technologie et de l'informatique sont les plus exposées aux candidats deepfake.

Selon Cyble, 30 % des incidents d'usurpation d'identité d'entreprise à fort impact en 2025 impliquaient des deepfakes, ce qui confirme que les médias synthétiques générés par l'IA sont passés d'une nouveauté à un élément central de la fraude ciblant les entreprises. Une planification efficace de la réponse aux incidents doit désormais tenir compte de ces vecteurs d'attaque basés sur l'IA.

Détecter et prévenir les escroqueries liées à l'IA

La défense contre les escroqueries liées à l'IA d'entreprise nécessite une détection multicouche couvrant l'analyse comportementale, la surveillance des identités et l'analyse réseau, car les contenus générés par l'IA contournent de plus en plus les contrôles de sécurité basés sur le contenu.

Voici un cadre structuré pour la défense contre les escroqueries liées à l'IA dans les entreprises :

- Déployez l'analyse comportementale et la détection et réponse aux incidents réseau (NDR ) — détection et réponse aux incidents identifie les modèles réseau anormaux associés à l'infrastructure des escroqueries basées sur l'IA, notamment les communications de commande et de contrôle, le trafic de synthèse vocale et les flux de données inhabituels.

- Mettre en œuvre la détection des menaces liées à l'identité — La détection et la réponse aux menaces liées à l'identité (ITDR) signalent les modèles d'authentification anormaux, les demandes d'accès inhabituelles et les écarts de comportement qui indiquent des identités compromises ou synthétiques.

- Exiger des contrôles de vérification à plusieurs niveaux — Imposer une double approbation pour les transactions financières via des canaux de communication distincts. Établir des phrases de vérification pré-partagées pour les communications d'urgence. Vérifier toutes les demandes de grande valeur via des canaux hors bande.

- Améliorez la formation à la sensibilisation à la sécurité — Déplacez l'accent de la formation de la détection des erreurs grammaticales vers la reconnaissance de la manipulation psychologique, de la création d'un sentiment d'urgence et des contextes de demandes inhabituelles. Les recherches d'IBM sur l'ingénierie sociale appliquée à l'IA confirment que la formation traditionnelle consistant à « repérer les fautes de frappe » est désormais inefficace.

- Déployez une sécurité des e-mails améliorée par l'IA — Utilisez un filtrage des e-mails basé sur le ML qui analyse les modèles comportementaux plutôt que les signatures de contenu uniquement. Le numéro 9 de Microsoft Cyber Signals explique en détail comment l'analyse comportementale permet de détecter ce que les outils basés sur les signatures ne parviennent pas à détecter.

- Mettre en œuvre l'authentification multifactorielle partout — Veillez à ce que l'authentification multifactorielle couvre tous les points d'accès, en privilégiant les méthodes phishing(FIDO2, jetons matériels) pour les comptes à privilèges élevés.

- Acceptez les limites de la détection des deepfakes — La détection des deepfakes basée sur le contenu est de moins en moins fiable à mesure que la qualité de génération s'améliore. Gartner prévoit que d'ici 2026, 30 % des entreprises jugeront les solutions autonomes de vérification d'identité peu fiables lorsqu'elles sont utilisées seules. La détection comportementale des menaces offre une couche complémentaire essentielle.

MITRE ATT&CK pour les menaces d'escroquerie liées à l'IA

La mise en correspondance des techniques d'escroquerie utilisant l'IA avec le MITRE ATT&CK aide les équipes GRC et les architectes de sécurité à intégrer les risques de fraude liés à l'IA dans les modèles de menaces existants.

Tableau : MITRE ATT&CK pertinentes pour les escroqueries basées sur l'IA. Légende : Correspondance entre les méthodes d'attaque des escroqueries basées sur l'IA et MITRE ATT&CK , avec des conseils de détection.

Cadre réglementaire en matière de fraude liée à l'IA

Le cadre réglementaire relatif à la fraude liée à l'IA se durcit rapidement.

- Profil NIST Cyber AI (IR 8596) — Publié le 16 décembre 2025, ce projet de cadre aborde trois domaines directement applicables à la défense contre les escroqueries liées à l'IA : la sécurisation des composants des systèmes d'IA, la mise en œuvre d'une cyberdéfense basée sur l'IA et la lutte contre les cyberattaques basées sur l'IA (NIST IR 8596).

- Mesures coercitives prises par la FTC — La FTC a engagé plusieurs actions contre des stratagèmes frauduleux basés sur l'IA, notamment dans des affaires impliquant de faux outils d'investissement basés sur l'IA qui ont escroqué les consommateurs d'au moins 25 millions de dollars.

- Décret présidentiel sur l'IA — Le décret présidentiel de décembre 2025 intitulé « Garantir un cadre politique national pour l'intelligence artificielle » établit un cadre réglementaire fédéral pour l'IA et crée un groupe de travail sur les litiges liés à l'IA.

- Lois étatiques sur l'IA — Plusieurs lois étatiques sont entrées en vigueur le 1er janvier 2026, notamment des réglementations en Californie et au Texas. La loi S.B. 24-205 du Colorado, qui traite des obligations en matière de gouvernance de l'IA, entrera en vigueur en juin 2026.

Approches modernes pour se prémunir contre les escroqueries liées à l'IA

Le secteur converge vers un paradigme de défense qui utilise l'IA pour contrer l'IA. Les approches actuelles comprennent l'analyse comportementale, la détection des menaces d'identité, l'analyse du trafic réseau, la sécurité des e-mails basée sur l'IA, les outils de détection des deepfakes et les plateformes de formation évoluées en matière de sensibilisation à la sécurité.

Plusieurs tendances façonnent le paysage. La détection unifiée sur les surfaces réseau, cloud, identité et SaaS remplace les outils cloisonnés qui ne surveillent qu'une seule surface d'attaque. Les deepfakes interactifs en temps réel posent des défis que l'analyse statique du contenu ne peut résoudre. Et l'IA agentique (des systèmes d'IA autonomes agissant au nom des utilisateurs) introduit de nouveaux vecteurs de fraude où des machines en manipulent d'autres.

Les signaux d'investissement confirment l'urgence. Adaptive Security a levé 146,5 millions de dollars au total, dont le premier investissement d'OpenAI dans la cybersécurité, axé spécifiquement sur la défense contre l'ingénierie sociale alimentée par l'IA. Quatre-vingt-quatorze pour cent des dirigeants interrogés par le WEF s'attendent à ce que l'IA soit la force la plus importante en matière de cybersécurité en 2026.

Dates clés à retenir pour les défenseurs : la date limite pour la déclaration de politique générale de la FTC, le 11 mars 2026 ; le rapport annuel 2025 du FBI IC3, attendu en avril 2026 ; et la mise en œuvre de la loi Colorado S.B. 24-205 en juin 2026.

Comment Vectra AI la détection des escroqueries liées à l'IA

L'approche Vectra AI consiste à détecter les comportements réseau et identitaires qui indiquent que les campagnes d'escroquerie basées sur l'IA ont dépassé le stade initial de l'ingénierie sociale. En surveillant les communications de commande et de contrôle anormales, les modèles d'authentification inhabituels et les flux d'exfiltration de données associés à l'infrastructure de fraude basée sur l'IA, Attack Signal Intelligence comble les lacunes des défenses basées sur le contenu et du jugement humain, qui échouent de plus en plus face aux attaques générées par l'IA. Cela correspond à la philosophie « assume-compromise » : il est plus fiable de trouver les attaquants déjà présents dans l'environnement que de prévenir toutes les tentatives d'ingénierie sociale améliorées par l'IA à la périphérie.

Conclusion

Les escroqueries liées à l'IA représentent la catégorie de fraude qui connaît la croissance la plus rapide dans le domaine de la cybersécurité, grâce à des outils gratuits, accessibles et anonymes. Les données sont sans ambiguïté : croissance de 1 210 % des fraudes liées à l'IA, 40 milliards de dollars de pertes prévues d'ici 2027 et 73 % des organisations déjà touchées.

Les entreprises qui parviennent à se défendre contre cette menace partagent des caractéristiques communes. Elles déploient une détection multicouche sur l'ensemble du réseau, des identités et des e-mails plutôt que de s'appuyer sur un seul contrôle. Elles mettent en œuvre des workflows financiers à double validation qui ne font confiance à aucun canal de communication unique. Elles forment leurs équipes à reconnaître les schémas de manipulation psychologique plutôt que les erreurs grammaticales. Et elles acceptent la réalité de la compromission : l'ingénierie sociale générée par l'IA réussira parfois, rendant la détection et la réponse rapides aussi cruciales que la prévention.

Pour les équipes de sécurité qui évaluent leur état de préparation, le cadre est clair. Cartographiez votre exposition aux escroqueries basées sur l'IA à l'aide des MITRE ATT&CK décrites ci-dessus. Évaluez si votre pile de détection actuelle couvre les anomalies comportementales du réseau, les menaces d'identité et les attaques par e-mail. Et assurez-vous que vos plans d'intervention en cas d'incident tiennent compte phishing de deepfake, de clonage vocal et phishing généré par l'IA.

Découvrez comment la plateformeVectra AI détecte les comportements réseau et identitaires qui indiquent des campagnes d'escroquerie basées sur l'IA, en repérant ce que les défenses basées sur le contenu ne détectent pas.

Principes fondamentaux liés à la cybersécurité

Foire aux questions

Comment savoir si une vidéo est un deepfake ?

Recherchez les incohérences subtiles dans l'éclairage, la synchronisation labiale et les micro-expressions faciales, en particulier autour des yeux, de la racine des cheveux et de la mâchoire. Les erreurs de synchronisation audiovisuelle et les clignements des yeux peu naturels peuvent également indiquer un contenu synthétique. Cependant, les nouveaux modèles de deepfakes éliminent de plus en plus ces artefacts visuels, rendant la détection basée sur le contenu peu fiable en tant qu'approche unique. Les responsables de la sécurité des entreprises ne doivent pas se fier uniquement à l'inspection visuelle. Les signaux comportementaux sont des indicateurs plus fiables : demandes inhabituelles, urgence, déclencheurs de transactions financières et communication par des canaux inattendus. En cas de doute, vérifiez l'identité de tout participant à un appel vidéo par le biais d'un canal de communication distinct et préétabli avant d'autoriser toute action. Gartner prévoit que 30 % des entreprises jugeront la vérification d'identité autonome peu fiable d'ici 2026.

Que faire si vous êtes victime d'une arnaque liée à l'IA ?

Pour les particuliers, cessez immédiatement toute interaction, contactez la partie usurpée via un canal vérifié que vous avez déjà enregistré, signalez l'incident à la FTC sur reportfraud.ftc.gov et au FBI IC3 sur ic3.gov, et alertez votre institution financière afin qu'elle gèle tous les comptes concernés. Pour les organisations, la réponse doit suivre votre plan d'intervention en cas d'incident : isolez les systèmes concernés, conservez toutes les preuves judiciaires (e-mails, enregistrements d'appels, journaux de chat, journaux réseau), vérifiez l'étendue de la compromission des systèmes d'identité et financiers, et informez les parties prenantes concernées conformément à votre manuel. Documentez les techniques d'IA spécifiques utilisées (vidéo deepfake, voix clonée, e-mail généré par l'IA), car ces informations aident les forces de l'ordre à suivre les schémas et à monter des dossiers.

L'IA peut-elle vous escroquer au téléphone ?

Oui. Selon une étude de McAfee, le clonage vocal par IA ne nécessite que trois secondes d'audio pour créer une correspondance vocale à 85 %. Les pirates obtiennent ces enregistrements audio à partir de vidéos publiées sur les réseaux sociaux, de messages d'accueil de messagerie vocale, d'enregistrements de conférences et même de brèves conversations téléphoniques. Les grands détaillants déclarent désormais recevoir plus de 1 000 appels frauduleux générés par l'IA par jour. Selon l'analyse de Fortune, le clonage vocal a franchi le « seuil de distinction », ce qui signifie que les auditeurs humains ne peuvent pas distinguer de manière fiable les voix clonées des voix authentiques. Les organisations doivent mettre en place des procédures de vérification qui ne reposent jamais uniquement sur la reconnaissance vocale. Utilisez des phrases codées pré-partagées, rappelez à partir de numéros vérifiés de manière indépendante et exigez une double approbation pour toute transaction financière autorisée par téléphone.

Qu'est-ce que l'abattage des porcs ?

Le « Pig butchering » (également connu sous le nom de « sha zhu pan ») est une arnaque à l'investissement à long terme dans laquelle les attaquants établissent une relation avec la victime pendant plusieurs semaines ou plusieurs mois (en « engraissant le cochon ») avant de la diriger vers des plateformes d'investissement frauduleuses. L'IA a industrialisé cette arnaque grâce à la gestion automatisée des personnalités. L'opération « Truman Show » de Check Point a déployé 90 « experts » générés par l'IA dans des groupes de messagerie contrôlés, créant ainsi un environnement social entièrement synthétique autour de chaque victime. Les victimes installent des applications mobiles contenant des données commerciales contrôlées par un serveur et affichant des rendements fictifs. Une fois que les victimes ont déposé des fonds importants, la plateforme devient inaccessible. Les données de Chainalysis montrent que les pertes liées aux escroqueries cryptographiques ont atteint 14 milliards de dollars en 2025, les opérations de « pig butchering » représentant une part importante de ce montant.

Comment fonctionnent les escroqueries sentimentales basées sur l'IA ?

Les escroqueries sentimentales basées sur l'IA utilisent des modèles linguistiques volumineux pour maintenir des conversations convaincantes et émotionnellement intelligentes à grande échelle sur les plateformes de rencontre et les applications de messagerie. Contrairement aux escroqueries sentimentales menées par des humains, qui nécessitent une personne par victime, l'IA permet à un seul opérateur d'entretenir simultanément des dizaines de relations, chacune avec un style de communication personnalisé. Le rapport « 2026 Future of Fraud Forecast » d'Experian identifie les bots émotionnellement intelligents alimentés par l'IA comme l'une des principales menaces émergentes. Ces bots adaptent leur ton, leur personnalité et leurs sujets de conversation à chaque cible, en apprenant leurs préférences au fil du temps. Les escroqueries s'intensifient généralement, passant des plateformes de rencontre à la messagerie privée, puis introduisant des crises financières ou des « opportunités » d'investissement fictives. Les victimes rapportent des interactions qui leur ont semblé profondément personnelles et authentiques au cours de relations qui ont duré plusieurs mois.

Qu'est-ce que la fraude d'identité synthétique ?

La fraude à l'identité synthétique utilise l'IA pour créer des identités fictives en combinant des données réelles, telles que des numéros de sécurité sociale volés lors de violations de données, avec des informations personnelles fabriquées, notamment des visages, des adresses et des antécédents professionnels générés par l'IA. Contrairement à l'usurpation d'identité traditionnelle, où un pirate prend l'identité d'une personne réelle, les identités synthétiques représentent des personnes qui n'existent pas, ce qui rend leur détection beaucoup plus difficile. Group-IB rapporte que des kits complets d'identité synthétique sont disponibles pour environ 5 dollars. Ces identités synthétiques sont utilisées pour ouvrir des comptes bancaires, demander des crédits, passer des vérifications d'emploi et établir des relations commerciales frauduleuses. Les institutions financières sont les plus exposées, mais toute organisation qui s'appuie sur la vérification d'identité lors de l'intégration est en danger.

L'IA peut-elle créer de faux sites web ?

Oui. L'IA peut générer à grande échelle des clones de sites Web convaincants, reproduisant l'image de marque, le contenu et les fonctionnalités des sites légitimes. Palo Alto Unit 42 a documenté le stratagème « Quantum AI », dans lequel des pirates ont créé de fausses plateformes de trading avec du contenu généré par l'IA, accompagné de données de performance fabriquées et de témoignages clients synthétiques. L'opération « Truman Show » de Check Point a utilisé des applications mobiles contrôlées par serveur disponibles sur les boutiques d'applications officielles. Experian prévoit que le clonage de sites web à grande échelle sera l'un des principaux vecteurs de fraude en 2026. Ces faux sites sont de plus en plus difficiles à distinguer des plateformes légitimes par simple inspection visuelle. Les organisations doivent surveiller l'utilisation non autorisée de leur image de marque et des variantes de leur domaine, tandis que les utilisateurs doivent vérifier la légitimité de la plateforme par le biais des canaux officiels avant de saisir leurs identifiants ou leurs informations financières.